Noticias Claves e implicaciones del nuevo reglamento de inteligencia artificial de la Unión Europea

4 de junio, 2024

PROTEGER DERECHOS FRENTE A LA IA

Albert Collado, socio del departamento de Derecho Tributario de Garrigues, dio comienzo a la sesión calificando la inteligencia artificial como “el cambio tecnológico más importante de nuestras vidas”. Citó un estudio de McKinsey, realizado a partir de encuestas a empresas y directivos, según el cual un tercio de las empresas ya están utilizando la IA para, al menos, alguna función de la compañía y una cuarta parte de los directivos ya la están empleando en sus tareas diarias. Los encuestados también coinciden en que será necesaria una recapacitación de los empleados.

No solo es importante para las empresas. En la vida cotidiana cada vez se usa más para obtener cualquier información por delante de los buscadores tradicionales, con el ahorro de tiempo que esto supone.

La nueva norma obliga a revelar si un contenido determinado está hecho con IA o es producto de la actividad humana

El reglamento aprobado el pasado 13 de marzo por el Parlamento Europeo está enfocado, según Albert Collado a “proteger los derechos fundamentales frente a los riesgos que genera la inteligencia artificial”. Obliga a revelar si un contenido determinado está hecho con IA o es producto de la actividad humana. A continuación presentó a los dos expertos invitados: Cristina Mesa, socia de Garrigues, y Manuel Berzosa, asociado sénior de Toda & Nel·lo.

El Reglamento es una norma jurídica de la legislación europea con alcance general y aplicación y eficacia directa. Es, por tanto, directamente aplicable en todos los estados miembros sin que sea precisa ninguna norma nacional adicional para completar su eficacia. Además, hace que sea posible invocar la tutela jurisdiccional ante los tribunales nacionales o comunitarios por parte de los particulares.

UN ENFOQUE CENTRADO EN EL RIESGO

Manuel Berzosa, asociado sénior de Toda & Nel·lo, realizó en primer lugar la siguiente definición de inteligencia artificial: “tecnología que emula la inteligencia humana y que no piensa sino que imita, del mismo modo que no tiene opiniones, sino que las refleja”. Añadió también que “si bien la IA no tiene intenciones, su uso sí tiene consecuencias, en concreto, puede causar desinformación y daño”.

Esta definición es corta, según Manuel Berzosa, comparada con la que recoge el reglamento de la UE, que intenta recoger todos los aspectos de la inteligencia artificial.

De la definición del reglamento, Manuel Berzosa indicó que lo más importante es, por una parte, que comprende el hardware, el software y el ser humano que trabaja con la IA y, por otra, que dispone de autonomía ya que aprende por sus propios medios. “Esta última es una cuestión esencial”, subrayó.

Existe un cierto debate sobre si la definición actual recogida en el reglamento será válida por mucho tiempo debido al cambio acelerado que experimenta este marco tecnológico.

Los sujetos de la mayoría de las obligaciones, según el reglamento, son los proveedores que pongan esta tecnología en el mercado, pero también los usuarios.

Existe un cierto debate sobre si la definición actual recogida en el reglamento de la UE será válida por mucho tiempo debido al cambio acelerado que experimenta este marco tecnológico

El enfoque que ha adoptado la Unión Europea en este reglamento está basado en el riesgo. Funciona con el siguiente principio: cuanto mayor riesgo existe de causar daño con la IA, más estrictas son las obligaciones. Esto conduce a establecer unas categorizaciones. En el caso de riesgo muy elevado asociado a una IA determinada, su uso será inaceptable (y por tanto implicará prohibición). Los sistemas que se valoran como de alto riesgo están permitidos, pero están sujetos a una serie de requerimientos precisos. Las obligaciones ya son más ligeras cuando el riesgo se clasifica como bajo.

ALGUNAS PRÁCTICAS EN EL PUNTO DE MIRA

Manuel Berzosa ofreció el ejemplo de una práctica realizada por Facebook en la que se manipularon distintas cuentas de usuarios para realizar un experimento psicológico. Precisamente una de las prácticas que está prohibida por el reglamento es la manipulación cognitiva o conductual.

Otro aspecto prohibido es la creación bases de datos a partir de la extracción de imágenes sin permiso. IBM creó una base de datos a partir de unas imágenes de Flickr, lo cual generó mucha polémica por el hecho de que no quedaba claro si los usuarios habían dado o no su consentimiento. La finalidad de esta base era tener disponibles muchas imágenes de rostros para entrenar a la IA.

También están en el punto de mira, como de alto riesgo, los sistemas de reconocimiento de emociones en el entorno laboral o los que asumen sesgos raciales o de género y que se aplican a la selección del personal. Incluso también aquellos sistemas que se utilizan para detectar fraude en la obtención de subsidios de desempleo de la administración (cuando se ha demostrado que no funcionaban correctamente).

Para estos casos de alto riesgo el reglamento establece claramente una serie de obligaciones y requerimientos legales que tienen que ver con la implantación de sistemas de gestión de riesgos en relación con la calidad de los datos que se van a utilizar, y la exigencia de documentación técnica, y de transparencia y vigilancia humana.

La norma también contiene un sistema de sanciones. en el caso de una infracción relacionada con el uso de las aplicaciones prohibidas se prevén sanciones de hasta 35 millones de euros

Manuel Berzosa señaló que, en su opinión, los elementos más relevantes son aquellos que están relacionados con la calidad de los datos ya que “muchas veces cuando se producen errores no se deben a déficits de los sistemas si no de los datos” y también los que se centran en la vigilancia humana de sistemas que presentan alto riesgo.

Todo ello plantea el reto de cómo acreditar que las tecnologías cumplen con los requisitos exigidos. En el caso de la puesta en el mercado de un producto la acreditación se realizará con una declaración de conformidad y un proceso de registro.

La norma también contiene un sistema de sanciones. En el caso de una infracción relacionada con el uso de las aplicaciones prohibidas se prevén sanciones de hasta 35 millones de euros. Y en el de la introducción de informaciones inexactas, incompletas o engañosas en el proceso de declaración de conformidad se prevén sanciones de hasta 7,5 millones de euros.

LIMITES A LA LIBRE UTILIZACIÓN DE DATOS

Cristina Mesa enfocó su intervención en cómo minimizar riesgos a la hora de implementar la inteligencia artificial en la empresa. Reconoció que la IA generativa ha desencadenado cierta preocupación por el hecho de que puede desempeñar muchas tareas que correspondían a las personas, sobre todo en esferas donde el lenguaje tiene protagonismo ya que, hasta ahora, la automatización afectaba principalmente a procesos industriales. El despacho Garrigues ha recibido muchas preguntas en torno a cuál es la mejor manera de implementar la IA en las compañías.

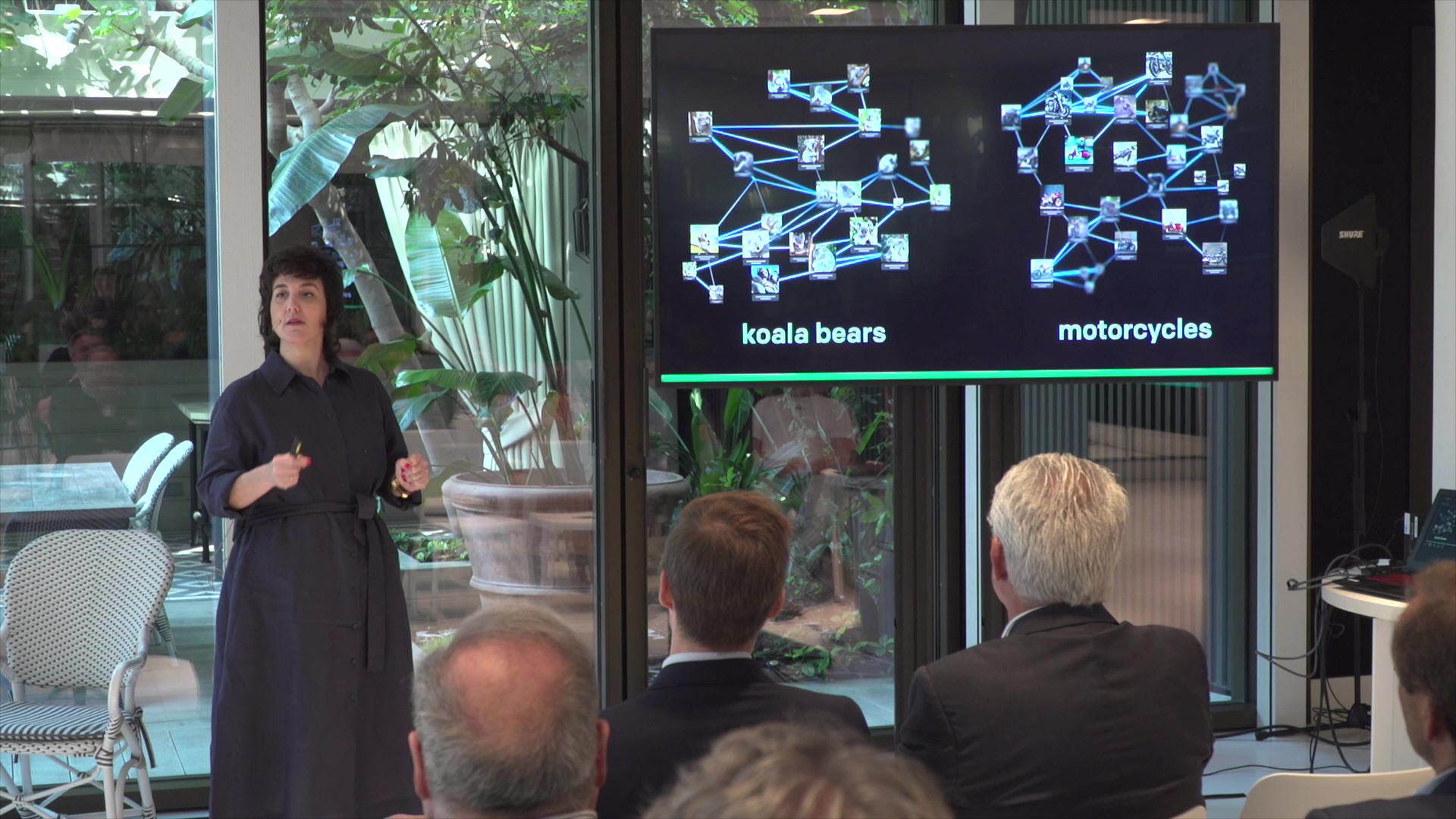

Para entender a fondo este tema, Cristina Mesa explicó cómo aprenden los sistemas de IA. Su percepción de un koala o una motocicleta, por ejemplo, se basa en ver miles de imágenes de koalas y motocicletas y extraer las características propias de estos conceptos, de manera que pueda reconocerlos y usarlos a posteriori.

Esta aprehensión de los conceptos las realiza de forma matemática: vectoriza las imágenes. Si se le pide a la IA que cree una imagen de un koala montado en moto la generara (de ahí el nombre “generativa”) por tanto es capaz de crear contenido nuevo y no solo reproducir el que ya existe.

Un problema legal que aparece en este contexto es que para “entrenar” a la IA con imágenes hay que tener en cuenta que muchas de ellas pueden estar sujetas a cuestiones de propiedad intelectual o estar relacionadas con aspectos de privacidad. Buena parte de los contenidos que se muestran en internet no son de libre utilización.

Para este caso, el legislador europeo ya estableció en 2018 la excepción de test and data mining para todas las organizaciones que usen la inteligencia artificial. Viene a decir, en síntesis, que es posible utilizar contenidos disponibles en la red en dos circunstancias: si la finalidad es la investigación pura (sin actividad comercial derivada) y si existe finalidad comercial, eso sí con la importante excepción en este último caso de que el titular del contenido lo prohíba.

Un problema legal que aparece en este contexto es que para “entrenar” a la IA con imágenes hay que tener en cuenta que muchas de ellas pueden estar sujetas cuestiones de propiedad intelectual

Un apunte al respecto es que la excepción de test and data mining no aplica si existe una marca de propiedad en una fotografía (la conocida marca de agua). Getty, por ejemplo, ha interpuesto demandas por uso de sus fotos con marca alegando que, si sirven de base a nuevas imágenes de baja calidad, eso dañaría su reputación.

Según Cristina Mesa, es relevante saber de qué manera formula la prohibición el titular de la imagen. Señaló que, en este momento, “no está del todo claro en algunas circunstancias cómo se puede poner una barrera a un contenido”. Lo más adecuado es -subrayó- “un modelo machine to machine, es decir, las máquinas hablen entre ellas para decidir sobre el uso o no de un contenido y, en este sentido, aseguró “esto ya se hace”.

En su opinión, “el legislador europeo lo ha hecho bastante bien, por eso no es de extrañar que gran parte de las demandas respecto a esta cuestión se produzcan en Estados Unidos”.

Microsoft ofrece sus productos a las empresas con una indemnity, esto es, con una cobertura para pagar una indemnización en caso de que un tercero demande al cliente de Microsoft por haber infringido derechos de propiedad.

Una peculiaridad dentro de este campo es que los resultados obtenidos por la inteligencia artificial no son protegibles y entran automáticamente dentro del dominio público. Por tanto aquellos que generen código con IA no tendrán ningún derecho de exclusividad sobre él.

Según Cristina Mesa, “en materia de propiedad intelectual e industrial los jueces son tremendamente duros porque la normativa también lo es”

Un concepto relevante es el overfitting, que es cuando un sistema de IA se nutre repetidamente de unos parámetros muy concretos de un objeto o concepto obtenidos de una sola fuente. En este sentido, si dicha fuente tiene copyright puede causar un problema legal. “Si nosotros como empresarios no tomamos medidas para impedir que esto suceda vamos a ser objetivamente responsables de ello”, indicó Cristina Mesa. Añadió que “en materia de propiedad intelectual e industrial los jueces son tremendamente duros porque la normativa también lo es”.

OPCIONES Y REGLAS DEL JUEGO

Las opciones y reglas del juego en la contratación de sistemas de IA generativa son cruciales y tienen que ser objeto de conocimiento por parte de las organizaciones. Es importante -subrayó Cristina Mesa- que a la hora de configurar el stack tecnológico de nuestra empresa sepamos exactamente qué queremos comprar y qué aspectos legales están relacionados con los instrumentos concretos que queramos adquirir”.

“Una opción es utilizar un modelo Open Source con lo cual se pueden adaptar muchas funcionalidades de terceros libremente y personalizarlas”, comentó. Otra consiste en desarrollar desde cero los sistemas y los datos. Esto tiene la ventaja de evitar el contacto con terceros y los problemas derivados , pero tiene como contrapartida que es muy costoso desde el punto de vista de la inversión.

Algunos sistemas son gratuitos o muy baratos porque utilizan nuestros inputs para entrenar los sistemas pero, si es así, hay que vigilar que la información que proporcionemos para este fin no sea confidencial

Si se opta por soluciones comerciales (es decir productos disponibles en el mercado para construir el stack tecnológico necesario) hay que cumplir con todos los términos y condiciones del creador del producto.

“Muchas veces estos sistemas son gratuitos o muy baratos porque utilizan nuestros inputs para entrenar los sistemas pero, si es así, hay que vigilar que la información que proporcionemos para este fin no sea confidencial”, según Cristina Mesa.

“Hay que tener en cuenta también que nadie puede ofrecer, comercialmente, la garantía absoluta de que un sistema no se va a equivocar, si lo hace es que está mintiendo”, destacó. Respecto a esta tema es posible preguntar a un proveedor cuál es el margen de error del sistema. Las soluciones comerciales garantizan que el instrumento (el sistema IA) funcionará como tal, pero no pueden asegurar los resultados, en el sentido que sean los más convenientes para el interés de la organización.

PREGUNTAS Y RESPUESTAS

Albert Collado preguntó a Manuel Berzosa qué consejos daría en caso de ser responsable jurídico de una empresa respecto al uso de inteligencia artificial por parte de la compañía.

Manuel Berzosa señaló que se trataba de una cuestión compleja que no se podía abordar en un momento, pero dijo que la primera recomendación sería conocer a fondo cómo funciona la tecnología. “Solo con una capacitación previa se podrá saber dónde están las problemáticas y afrontarlas”, indicó.

También señaló que las direcciones de las empresas deben establecer medidas códigos de conducta para tratar adecuadamente con la IA por convicción y para cumplir con el marco regulatorio.

Otro aspecto tratado en las preguntas y respuestas fue hasta qué punto la regulación europea sobre IA puede afectar negativamente la competitividad cómo sostienen algunas opiniones. Para Cristina Mesa la preocupación es que, al tratarse de un tema de compliance, las empresas que tengan menos recursos serán las que tendrán más dificultad para cumplir, “ hay que decir sí al reglamento pero acompañado de la financiación que han recibido las empresas en los Estados Unidos”.

En esta parte final, también se indicó que en algunos casos los prompts pueden ser objeto de protección como propiedad intelectual siempre que cumplan con determinadas condiciones de “originalidad y complejidad”.

Otra cuestión señalada es que, a pesar de que un resultado de la IA no sea protegible, si alguien modifica y añade novedades a ese resultado, eso cambia su naturaleza y pasa a ser considerado una “obra original” y en consecuencia será protegible.

Las obligaciones establecidas por el reglamento europeo no son solo para las empresas sino también para las administraciones que también están sujetas a sanciones en caso de no cumplir con la norma. Hay una excepción que es el ámbito de la defensa.